vLLM on Kubernetes

Posted on

Updated on

309 words,

2 minutes to read

Contents

Overview

vLLM を Kubernetes で使いたいとき、production を意識して高スループットの選択肢について考えます。

私のほうで目をつけている選択肢は以下です。

ソフトウェア概要

それぞれいくつかの観点で比較してみます。(それぞれの情報は、執筆時点のものです。)

| 項目 | AIBrix | Production Stack | llm-d | Dynamo |

|---|---|---|---|---|

| 開発主体 | ByteDance | LMCache Lab | Red Hat | NVIDIA |

| GitHub Stars | 3.8k | 1.4k | 1.2k | 4.3k |

| 最新バージョン | 0.3.0 | 0.1.5 | 0.0.8 | 0.3.0 |

| デプロイ方法 | Manifest | Helm | Installer (.sh) | Operator |

気になるサービス機能

| 項目 | AIBrix | Production Stack | llm-d | Dynamo |

|---|---|---|---|---|

| Prefill/Decode Disag. | ||||

| KV Cache Offloading | ||||

| KV Cache Aware Routing | ||||

| Multi LoRA Serving | ||||

| Benchmarking |

(うんぬん)

Prefill/Decode Disaggregation

- llm-d

- Dynamo

気になる管理機能

| 項目 | AIBrix | Production Stack | llm-d | Dynamo |

|---|---|---|---|---|

| Security Consideration | ||||

| Observability |

(うんぬん)

アーキテクチャ

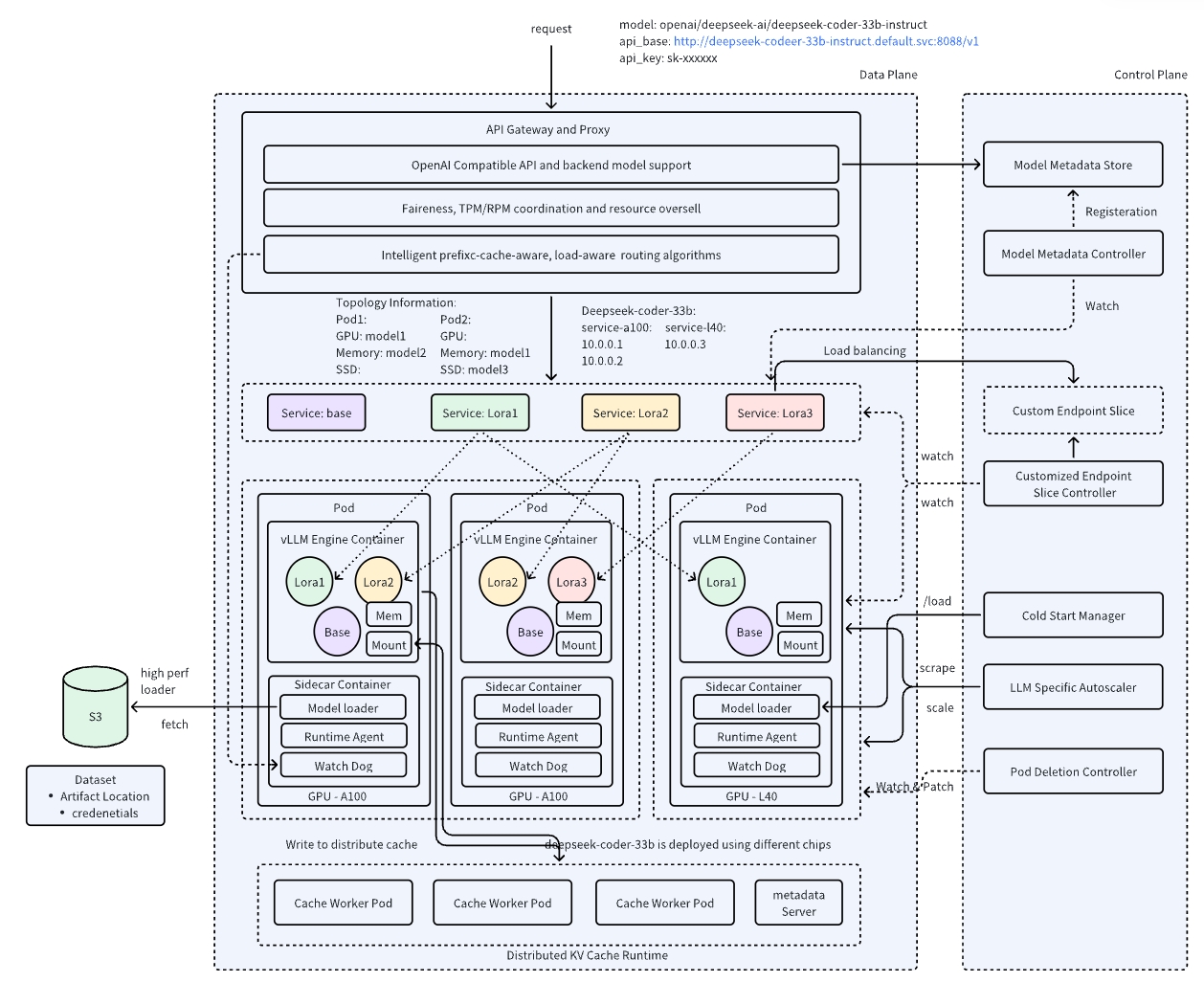

- AIBrix

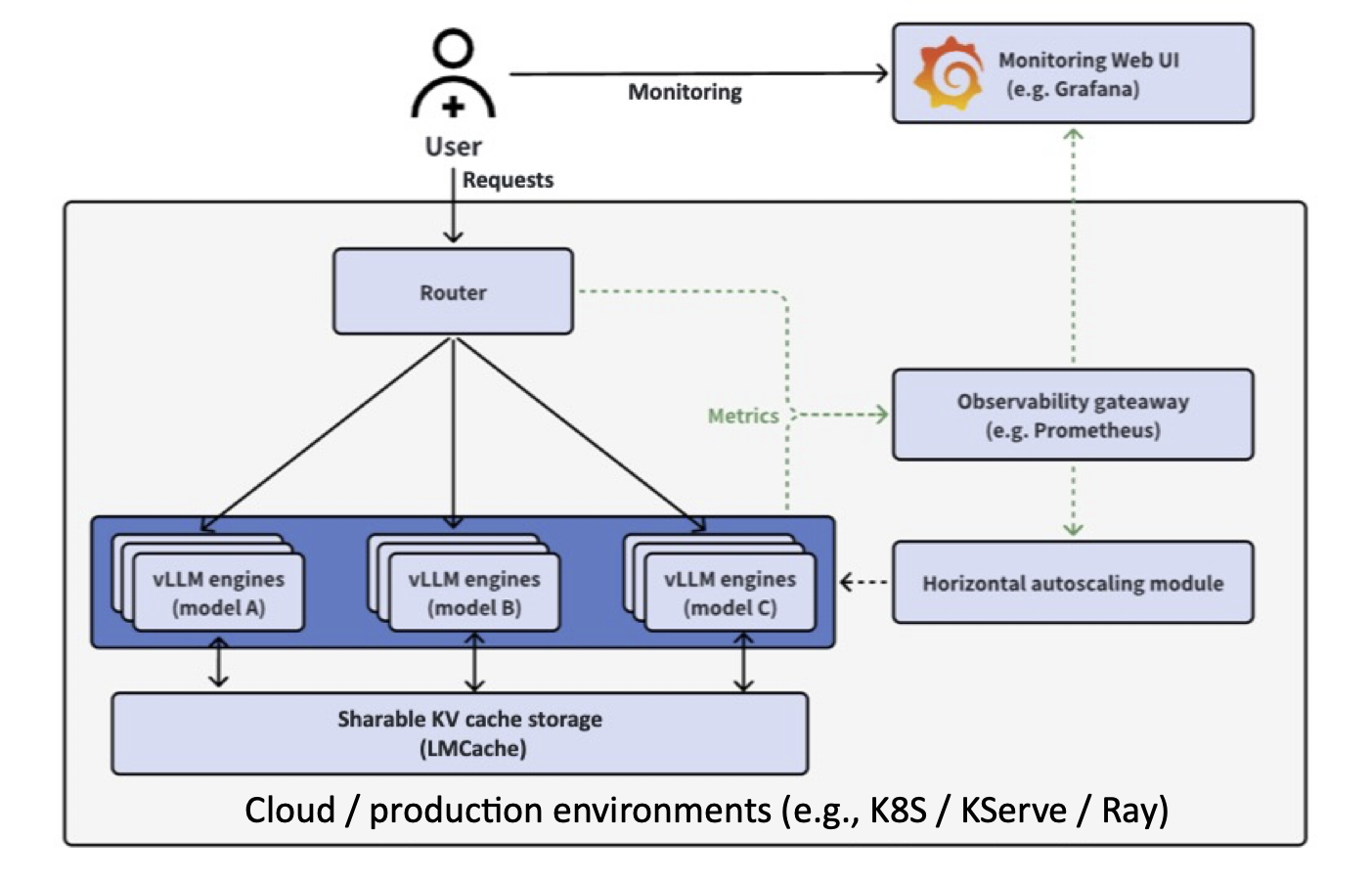

- vLLM Production Stack

- llm-d

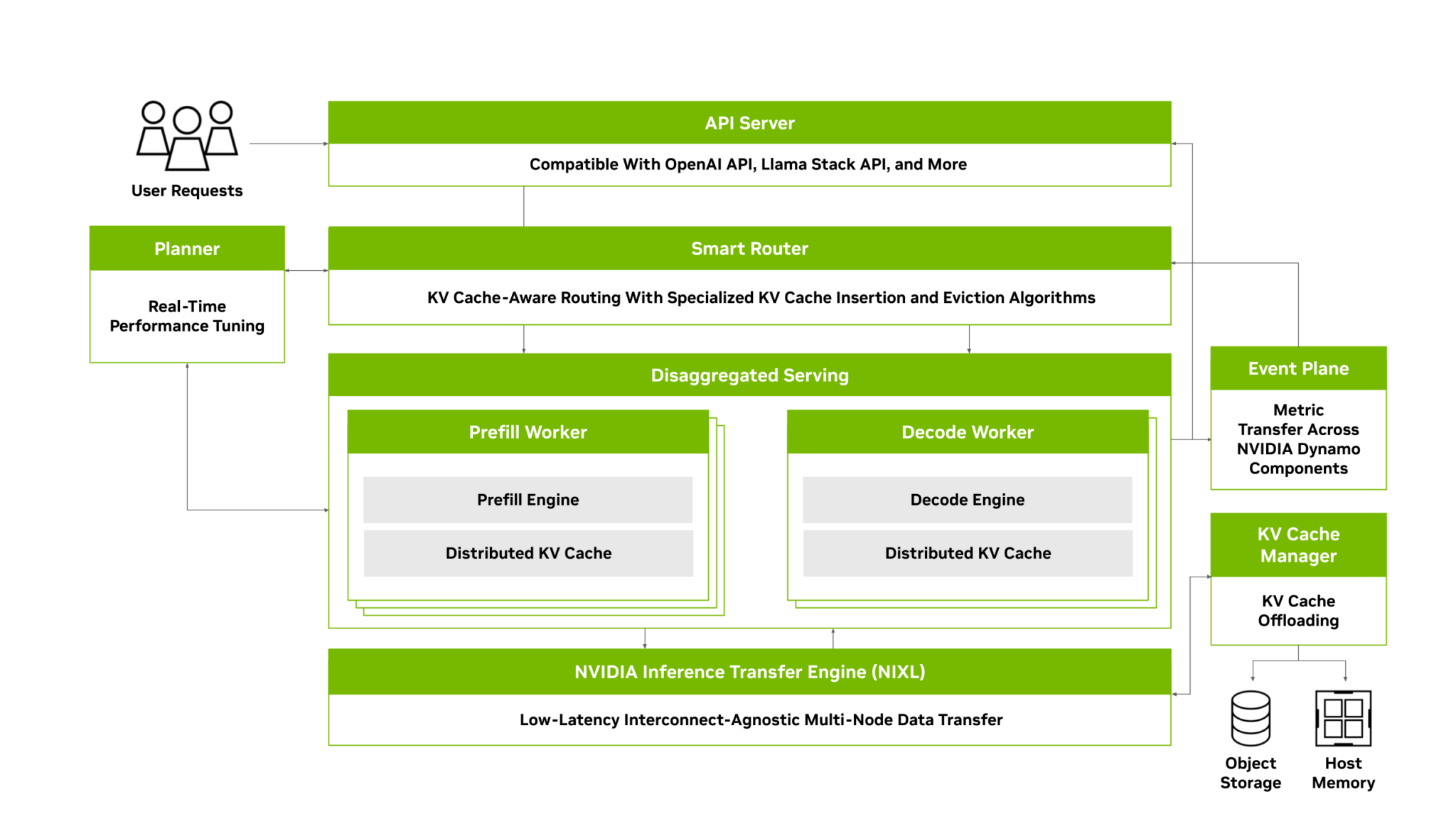

- Dynamo

どれも、まだ開発初期といったところでしょうか。ただ、kubernetes 上での高スループットの推論エンジンは実用性が高まっているので、今後も注目していきます。